Etichettato: maurizio sgroi

Cartolina. Comincia con la D

Quando leggo che alcuni volenterosi componenti dei BRICS vorrebbero costruire un circuito finanziario internazionale alternativo a quello attualmente funzionante, che evidentemente viene giudicato di parte e per giunta di parte non affidabile, mi viene in mente la storia dell’idraulico che decide di costruire un nuovo complesso sistema di tubature ma poi rimane senz’acqua. Mettiamo pure che i BRICS si facciano il loro SWIFT, come sogna la Russia da qualche anno, e che mettano insieme anche un sistema evoluto di pagamenti transfrontalieri totalmente staccato da quello corrente, come ha fatto la Cina col suo CIPS. Rimane la domanda: che tipo di moneta dovrebbe circolarci dentro? Forse la valuta cinese, attualmente non convertibile? O magari il rublo? E quanti rubli o yuan servirebbero per alimentare un flusso di scambi fra un gruppo di paesi che esprime quote crescenti del pil mondiale e che si candida ad essere se non antagonista quantomeno alternativo? E con quale moneta poi questi paesi pagherebbero gli scambi con i paesi che non appartengono al loro circolo? Tirate a indovinare. Comincia con la D.

L’inesorabile declino dei redditi netti da capitale in Italia

Vale la pena osservare, visto quanto poco se ne parla malgrado sia un piccolo fatto storico, che l’anno scorso per la prima volta dal 2015 l’Italia ha avuto un saldo netto negativo dei redditi primari della bilancia dei pagamenti.

Malgrado la definizione esoterica, si tratta di una variabile molto semplice da comprendere: in sostanza il saldo misura la somma algebrica degli scambi di denaro che derivano dalla remunerazione dei fattori produttivi, ossia capitale e lavoro, fra i soggetti che risiedono in Italia e quelli che vivono all’estero. Ne fanno parte, ad esempio, gli interessi obbligazionari che gli italiani incassano dai loro investimenti esteri e quelli che i debitori obbligazionari italiani pagano agli investitori esteri.

Nel 2023 questo saldo è arrivato in territorio negativo (linea nera grafico sopra) appesantito dalla diminuzione di 23 miliardi registrata sui redditi da capitale, che a differenza di quelli da lavoro rimasti stabili – sono peggiorati drammaticamente.

Nel suo ultimo Bollettino economico Bankitalia ha spiegato che tale peggioramento “si è concentrato nella componente degli “altri investimenti”, che includono soprattutto prestiti e depositi a breve o brevissimo termine con controparti non residenti”. In pratica stiamo parlando di debiti di soggetti italiani a breve termine verso prestatori esteri. La tipologia di questi debiti – il breve o brevissimo termine – ha fatto sì che reagissero immediatamente all’aumento del livello dei tassi di interesse.

L’Italia, come si può osservare nel grafico sopra a destra, è fra i paesi più pesantemente esposti a questo tipo di investimento. Dal saldo Target, infatti, si osserva che gli “altri investimenti” a debito dell’Italia pesavano, nella media del 2023, ben 772 miliardi, in gran parte motivato dal saldo Target, che era negativo per 598 miliardi, e viene remunerato al tasso di interesse ufficiale che la Bce fissa sulle operazioni di rifinanziamento.

Per farla breve, l’aumento dei tassi di interesse ha pesato ben 18,7 miliardi di esborsi per i residenti italiani verso l’estero, a cui si sono aggiunti altri 5,2 miliardi di euro versati dalle banche italiane esposte a breve e brevissimo termine verso investitori non residenti. Ed ecco che arriviamo ai 23 miliardi di deficit che ha fatto sprofondare il saldo.

Il rialzo dei tassi ha avuto effetti assai minori sulla posizione obbligazionaria italiana, che espone un saldo attivo per 559 miliardi ma che ovviamente reagisce assai meno agli aumenti dei tassi per la semplice ragione che le obbligazioni hanno scadenza più lunghe. Al tempo stesso sul lato delle passività, il calo dell’inflazione ha avuto un effetto positivo sulle cedole pagate agli investitori esteri, che ovviamente si sono ridotte, e che pesano circa un sesto del totale degli stock dei nostri debiti obbligazionari esteri.

In sostanza, ciò che è accaduto è che le esposizioni a breve termine, non compensate dal quelle a lungo, hanno duramente penalizzato i nostri redditi primari. Vista la struttura del nostro indebitamento, e la tendenza dei tassi di interesse a rimanere ancora elevati, è improbabile che nel medio termine i redditi primari da capitale tornino positivi. Il che non aiuta il nostro equilibrio estero. Meglio ricordarlo.

Nella globalizzazione che cambia, fra i due litiganti i terzi godono

Chi dubitasse della saggezza dei proverbi, dovrebbe leggere l’interessante discorso che Gita Gopinath, vice direttore del Fmi, ha presentato lo scorso 7 maggio allo Stanford Institute for Economic Policy Research, nell’ambito di una serie di incontri dedicati alla discussione sul futuro del sistema monetario internazionale. Piatto ricco, quindi. Nel quale è assolutamente consigliato ficcarsi – sempre a proposito di proverbi – perché se ne trae un ottimo nutrimento intellettuale, oltre ad aggiornare i dati e le tendenze recenti della globalizzazione.

Il titolo dell’intervento è infatti “Geopolitics and its Impact on Global Trade and the Dollar”, in pratica l’universo mondo, col vantaggio di essere contenuto in una dozzina di pagine con molte figure. L’ideale per un mondo sempre meno alfabeta.

Fra queste figure ho scelto quella che apre questo post perché conferma, appunto, un vecchio proverbio che vale da sempre e quindi anche oggi: fra i due litiganti il terzo gode. Nella sua versione aggiornata dovremmo parlare di terzi più che di terzo, ma il principio rimane lo stesso.

Fuor di metafora, il Fmi osserva che il peggioramento delle relazioni fra Cina e Usa ha finito con l’avvantaggiare alcuni paesi – e fra questi si segnala il Messico – verso i quali all’aumento della quota di importazioni dagli Stati Uniti ha corrisposto da un lato l’aumento di importazioni dalla Cina e l’aumento di investimenti esteri cinesi sul loro territorio.

Diciamolo meglio. Questi paesi “connettori”, come li chiama il Fmi, hanno venduto più merci negli Usa, ma ne hanno comprato di più dai cinesi, che hanno spostato anche investimenti diretti su di loro. Questa interessante tipologia di scambi può assumere diverse forme. Esempio: la Cina apre in Messico una fabbrica di semilavorati per automobili che alimenta con materie prime importate dalla Cina e che vengono esportati negli Usa. In sostanza questi paesi fanno il lavoro che prima facevano i cinesi per gli americani.

Questa interposizione ovviamente allunga la catena di fornitura e quindi tende ad aumentare i costi, e chissà quanto migliora la produttività. Sicuramente i paesi connettori ci guadagnano, e i politici che promuovono questi processi possono dire che adesso fanno near-shoring, ossia si approvvigionano da paesi “amici”.

Si tratta, insomma, di un espediente intelligente per alzare la voce senza farsi troppo male. Ma rimane da vedere se basterà a garantire quell’ordinato movimento di scambi che serve a mantenere in piedi il commercio internazionale. Che il tempo volga al brutto è noto a tutti, e basta vedere l’aggiornamento del numero di restrizioni che i vari paesi impongono agli scambi globali.

Non bisogna spaventarsi troppo: la globalizzazione trova sempre le strade dove rivolgersi, come dimostra il piccolo esempio dei terzi che godono fra i due litiganti. Anche perché queste osservazioni devono essere condotte sul lungo periodo, per capire quanto siano profonde. E al momento la storia tifa per la globalizzazione, non il contrario.

Questo non vuol dire che vada tutto bene. Ma che può andare molto peggio. E quanto pare stiamo facendo del nostro meglio per provarlo.

I chiaroscuri di Ocse disegnano un mondo che va piano senza andare molto lontano

C’è spazio per ogni sentimento, ammesso che un rapporto di economia sia capace di generarne, nell’ultimo rapporto Ocse sullo stato economico del mondo, chiamiamolo così, anche se ormai l’economia è solo il punto di vista scelto per disegnare la straordinaria complessità nella quale siamo immersi e della quale siamo osservatori stupefatti.

Ci sono luci e ombre, insomma, come si diceva una volta. C’è la crescita, ma non abbastanza robusta. L’inflazione rallenta, ma accelera la tensione fiscale. I commerci cercano di riprendersi, ma le inimicizie aumentano. E così declinando, viene fuori l’immagine di un mondo che va piano ma non va molto lontano. Almeno non ancora.

S’indovina, in questo andamento esitante, la sostanziale difficoltà che agita i nostri policy maker, che forse non hanno ancora maturato il significato dell’espressione “mondo interconnesso”, che Ocse piazza in cima al suo Outlook. “Un pianeta, un popolo”, dicono quella che la fanno semplice, mentre semplice non lo è affatto.

E di questa complicazione, che è un attributo della complessità ma non la esaurisce, sembriamo tutti vittime impotenti. Cosa ci serve per agire globalmente, avendo consapevolezza di questa interconnessione?

Ocse nelle sue prolusioni ha gioco facile a promuovere il multilateralismo, che in un mondo sempre più guerreggiato somiglia a una forma di saggezza da salotto, destinata ai pochi che sono in grado di comprendere senza riuscire però ad agire. Specie quando questa saggezza viene elargita nel mondo in cui due pilastri del mondo libero – gli Usa e l’Ue – vanno a elezioni sotto molte nubi che favoriscono sicuramente il tratto in chiaroscuro del discorso Ocse. Cosa ne sarà, tanto per cominciare, delle relazioni fra questi due soggetti che intanto esprimono reciprocamente una quota rilevante del commercio internazionale?

E’ talmente ovvio che abbiamo bisogno di multilateralismo che l’Ocse, e in buon compagnia, lo ripete in ogni suo aggiornamento. Così come è talmente ovvio che dobbiamo migliorare le politiche dal lato dell’offerta – capaci cioè di far salire la produzione passando per il miglioramento del capitale umano – che l’Ocse, in buona compagnia, lo scrive in ogni rapporto compreso questo.

Il problema di queste “ramanzine”, sia detto bonariamente, è che fanno credere che davvero basti che i potenti della Terra si siedano attorno al solito tavolo e si accordino. Che è sicuramente necessario, ma certo è insufficiente se in via prioritaria non si comprendono le ragioni per le quali andiamo sempre più piano senza andar lontano. Dov’è che il nostro motore si è inceppato?

Per dirla diversamente, serve una dose di filosofia in più per completare la ricetta del rapporto dello stato del mondo di Ocse. E certo non possiamo aspettarci che Ocse assuma anche filosofi nei suoi staff. Quindi cominciamo a pensarci da soli. Chi ha idee le tiri fuori. I grandi cambiamenti cominciano così.

Cartolina. I nuovi giapponesi

Il Giappone, vero avanguardista delle nostra modernità, avrà molti imitatori nei prossimi decenni. La Cina, per esempio, che si prevede arriverà ad avere un debito pubblico superiore al 200 per cento entro un ventennio, quando l’America correrà verso il 150 per cento. Numeri del Giappone dei primi del nuovo secolo. Nel frattempo tutti avranno imitato fino allo sfinimento le politiche monetarie giapponesi – il QE lo hanno inventato loro, non la Fed – e stanno invecchiando drammaticamente, proprio come invecchiano i giapponesi, con le città piene di anziani e senza figli. Un giorno magari qualcuno ci spiegherà perché l’estremo Oriente somiglia così tanto all’Occidente estremo. Intanto abbiamo scoperto i nuovi giapponesi.

Un buon 2023 per il settore dei servizi italiani

E’ sicuramente una buona notizia che anche l’ultimo trimestre del 2023, proseguendo il dato positivo del terzo, dopo che i primi due erano stati negativi, abbia visto il nostro export di beni in ripresa. Ma è una notizia ottima, e purtroppo non abbastanza osservata, che il nostro settore dei servizi abbia visto una crescita costante per tutto l’anno, totalizzando una crescita delle esportazioni dell’8,2% rispetto al 2022, a fronte di un aumento del 4,3% delle importazioni.

Molto di questo successo si deve al settore turistico, che ha visto crescere la presenza di viaggiatori dall’estero nel nostro paese e purtroppo il bollettino di Bankitalia, da dove il dato è stato estratto, non approfondisce ulteriormente questa tematica.

Cercheremo di osservare più in profondità in uno dei prossimi post. Intanto però possiamo vedere che il miglioramento del settore dei servizi ha quasi azzerato il peso negativo che questa componente ha sul nostro conto corrente, che ormai da diversi trimestri ha pure visto diventare negativa la quota derivante dai redditi.

Come si può notare, ormai sono rimasti solo i beni non energetici a tenere in equilibrio i nostri conti con l’estero, e infatti il saldo, per quanto rimasto in zona positiva, è molto diminuito, col risultato che siamo esposti ai capricci della congiuntura internazionale, dovendo peraltro fare i conti con una bilancia energetica particolarmente sfavorevole.

E’ chiaro che dobbiamo crescere di più anche nelle altre componenti. E poiché i redditi primari dipendono da molte variabili esogene, a cominciare dall’andamento dei tassi di interesse, l’unica area sulla quale si può pensare di intervenire è quella dei servizi. Sarebbe sicuramente utile iniziare a discuterne.

Cartolina. Brothers in arms

Quando i tanto esecrati anni ’80 producevano quella globalizzazione selvaggia che tanto scandalizza i nostri benpensanti, con l’URSS a consegnare alla storia la sua triste esperienza politica, la spesa per gli armamenti lentamente declinava, consegnando il mondo agli anni Novanta, quando la spesa complessiva si inchiodava intorno ai 1.000 miliardi, che comunque non sono pochi. Poi gli anni Novanta finirono, e cominciò il nuovo secolo, portando con sé diversi guai. E la spesa militare iniziò a salire. Col rallentare dei commerci, che è un modo pacifico di competere, accelera la spesa militare, che è un modo poco pacifico di competere. Al punto che adesso, quando da un pezzo ha superato i 2.000 miliardi, molti ricordano un’altra corsa agli armamenti che nessuno ha dimenticato: quella che mise fine alla Belle époque. La storia non si ripete, ovviamente. Ma quando si somiglia c’è sempre da preoccuparsi. Almeno un po’.

I redditi stagnanti delle famiglie italiane non sostengono i consumi

L’ultimo Bollettino economico di Bankitalia conferma la debolezza dei consumi delle famiglie italiane, che hanno evidentemente risentito della cattive condizioni create dall’ondata inflazionistica e hanno subito un notevole calo del potere d’acquisto reale.

Le conseguenze di questa situazione sono osservabili se guardiamo l’andamento del pil nelle sue diverse componenti.

Notate che la linea rossa dei consumi è praticamente ferma, e non da oggi. In pratica sono inchiodati ai livelli del 2019. La nostra crescita è dipesa in larga parte dagli investimenti, cresciuti del 30 per cento dal 2019, e dall’export.

Il fatto che una grande economia come quella italiana non riesca ad esprimere un flusso di consumi delle famiglie robusto – ovvero l’asso nella manica della crescita americana – è segno di una profonda inadeguatezza nella struttura dei redditi che purtroppo rimangono stagnanti.

Il grafico che apre questo post ci consente di osservare che l’indice 100, che peraltro fa riferimento al 2015, è quello attorno al quale gravita la linea rossa del reddito reale lordo. Se guardiamo i pallini rossi, che indicano i valori puntuali, ci accorgiamo che in alcuni momenti recenti, ossia quando l’inflazione ha morso più selvaggiamente, siamo scesi ben sotto 100, quindi sotto il livello del 2015. E l’inflazione non è certo diminuita da allora. I prezzi acquisiti non scenderanno. Il meglio che possa capitare è che crescano meno di prima. E infatti la propensione al risparmio è letteralmente crollata arrivando sotto il valore del 2017.

In questo condizioni è molto difficile arrivare a esprimere una domanda di consumi dinamica. E questo ovviamente impatta sulla produzione. “Le imprese industriali continuano a individuare nella carenza della domanda il principale fattore che limita la propria produzione”, scrive Bankitalia. E così ci troviamo a dipendere dalla domanda estera, con tutte le complessità che questo genera, per sostenere la nostra economia.

Risolvere una questione così complessa non ha certo facili soluzioni. La risposta facile “aumentiamo gli stipendi” è uno slogan e nulla più. Solo chi pensa che l’economia sia una specie di computer programmabile può pensare di aumentare gli stipendi con una bacchetta magica.

Ciò per dire che il tema è molto reale, ma non si può fantasticare troppo sulle soluzioni. Anche perché le retribuzioni italiane crescono pochissimo da parecchi anni ormai. E se fosse stato facile, avremmo già risolto il problema. Purtroppo non lo è. E questo è un notevole handicap per tutti noi.

Cartolina. Perturbazione stabile

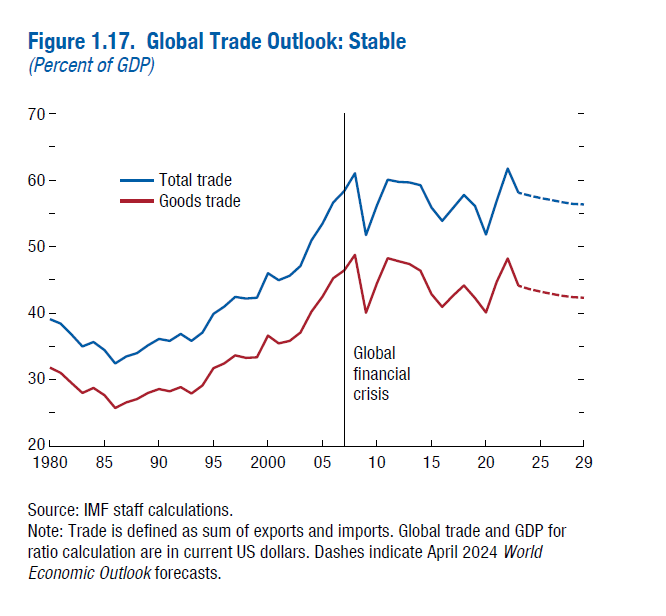

Il commercio internazionale non esprime certo la sua forma migliore, quella che l’ha portato dal 35 al 60 per cento del pil mondiale fra la metà degli anni ’80 del XX secolo e la metà degli anni Dieci del XXI, ma gode tutto sommato – e c’è molto da sommare – di una buona salute. I teorici – e i pratici – della de-globalizzazione dovranno farci i conti. Le previsioni per gli anni a venire lasciano indovinare una certa stabilità. Niente faville, ma neanche crolli. A meno di catastrofi imprevedibili, ovviamente. Rimane, strisciante, infatti, una certa perturbazione, che si indovina nei discorsi di fastidio che si ascoltano da parte dei tanti che vedono ancora l’internazionalizzazione come un disturbo della loro quiete, salvo poi postare il loro scontento sui social col loro smartphone prodotto chissà dove. La stabilità, costantemente perturbata, del commercio internazionale, trova il suo rovescio nella perturbazione stabile di queste persone. Sempre più numerose.

Cartolina. La globalizzazione umana

La globalizzazione di cui non si parla, perché spaventa le nostre opinioni pubbliche che purtroppo invecchiano male, è quella delle persone, che è antica quanto il mondo. Siamo migranti da quando abbiamo iniziato a camminare in posizione eretta, e nel nostro muoverci abbiamo sviluppato la nostra storia e noi stessi. L’espansione dell’umanità è innanzitutto una storia migratoria di successo. Anche oggi è così, solo che rimane in ombra l’enorme contributo che la migrazione dà alle nostre società malgrado il costante levarsi di muri costruiti sulle paure, sapientemente coltivate, di chi non vuole vedere la realtà. Che invece è chiarissima: negli ultimi tre anni la partecipazione al lavoro dei “foreign born”, come li chiama il Fmi, è cresciuta moltissimo in Europa e negli Usa, a differenza di quella degli indigeni, che sono sempre meno e sempre più vecchi. A fronte di ciò abbiamo mercati del lavoro vibranti, retribuzioni che stanno crescendo, produzione resiliente, malgrado tutti i disastri che ci sono capitati. La globalizzazione degli uomini, insomma, ha staccato il suo dividendo alle nostre società ingrate. Lo ha sempre fatto.