L’Italia non è da decenni un paese per giovani imprese

La senescenza ha radici profonde e lunghe almeno quanto la vita che si porta sulle spalle e conseguenze durature che impattano come forze gravitazionali su tutto ciò che vi ruota intorno. Vale per le persone, ma anche le per i sistemi economici, che invecchiano più o meno bene a seconda delle opportunità che riescono a generare. L’antidoto contro la senescenza è la capacità di innovare. L’alternativa è un graduale senso di immobilismo che conduce inevitabilmente alla stagnazione.

Ci sono molte spiegazioni che consentono di farci un’idea della ragioni del ristagno che affligge la nostra economia da oltre un ventennio, a esser generosi. Un recente paper di Bankitalia (“A country for Incumbent firms? Evidence on manifacturing investments in Italy in tha 20th century”) aggiunge un altro elemento alla nostra collezione di moventi.

Una lettura molto utile, non solo per gli appassionati di storia economica, che troveranno molte ragioni di sorpresa, ma anche per i policy maker di oggi. Non siamo divenuti senescenti d’improvviso. Risalire la linea del tempo, dai primi anni del secolo scorso come fa la ricerca, ci permette di capirlo meglio e di farcene qualche ragione in più.

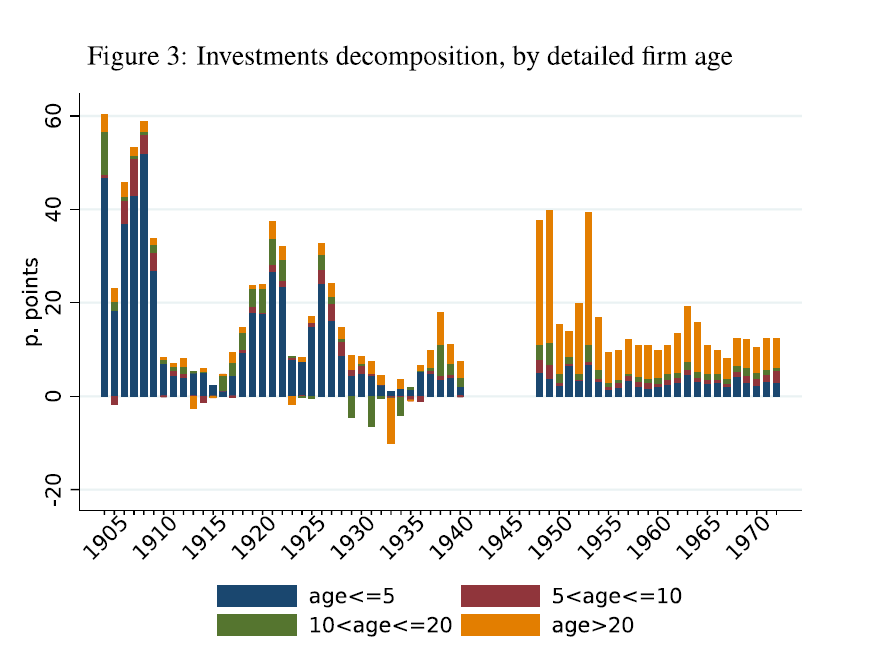

L’analisi, condotta spulciando le statistiche degli investimenti in manifattura, riporta alcune evidenze che si possono rapidamente riepilogare. La prima è che fino agli anni Venti del secolo scorso l’accumulazione di capitale era dovuta in larga parte al contributo di aziende di recente costituzione. Un fatto di per sé non sorprendente. L’Italia si era fatta da poco e c’era molto su cui investire per mettere in piedi il paese. Pensate solo alle ferrovie o all’industria automobilistica, che proprio in quel periodo metteva radici.

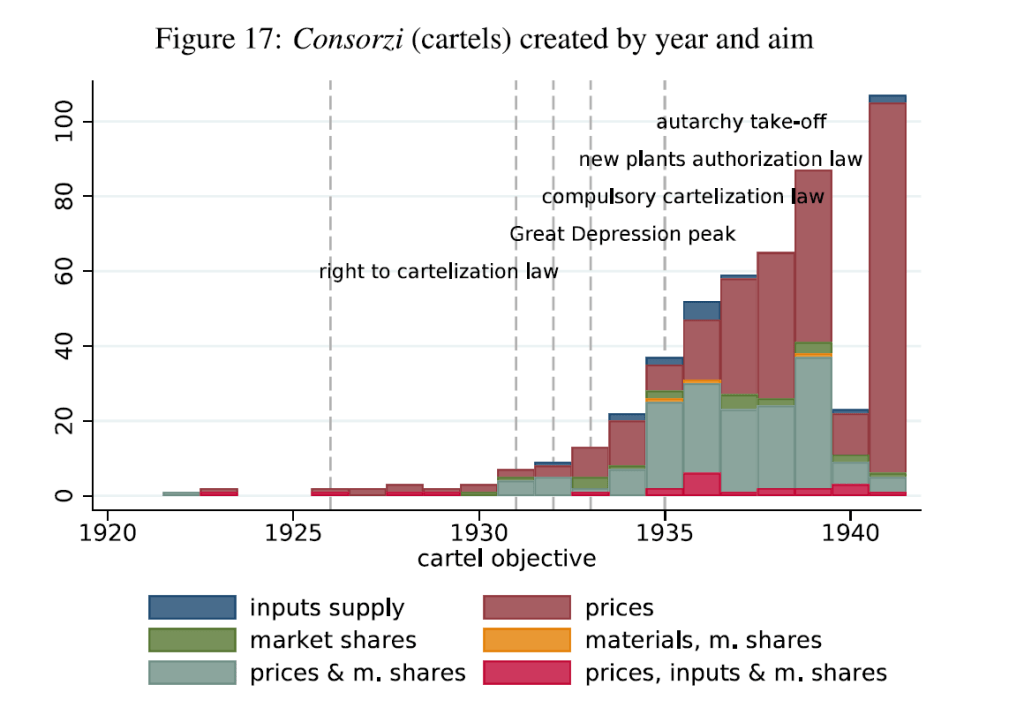

La grande depressione del 1929 mutò sostanzialmente il paradigma. E ciò avvenne per due ordini di motivi. Uno tecnico: il sostanziale fallimento del sistema bancario, che mise fine al modello della banca universale e condusse alle riforme bancarie culminate in quella del 1936, rivoluzionando sostanzialmente le modalità di finanziamento delle imprese, che subirono diversi impedimenti. Il secondo motivo è politico. L’avvento del fascismo condusse a un modello di politica economica accentrato sul controllo statale, della quale la nascita dell’Iri segnò l’apice, che concorse a una crescente riduzione della logica competitiva, in linea con lo spirito del tempo. Gli anni Trenta del secolo scorso furono quelli dell’autarchia, che si declinò col fiorire delle restrizioni commerciali e dei cartelli.

Il risultato fu che le aziende già presenti furono favorite rispetto a quelle che gradualmente iniziavano a nascere. Gli incumbent poterono godere di un chiaro vantaggio, che si tradusse nella quota crescente d investimenti che proveniva da queste aziende.

Negli anni del dopoguerra questo sbilanciamento risulta ancora più evidente. L’economia uscita dalla guerra era invecchiata insieme al paese. L’innovazione o proveniva dagli incumbent o si riduceva al lumicino.

Questo non implicò un insuccesso, al contrario. Nel secondo dopoguerra l’occupazione nel settore industriale passò dal 20 al 40% del totale, mentre il pil reale pro capite cresceva di sei volte. L’economia italiana stava diventando matura. La senescenza vera a proprio arriva alla fine del secolo scorso, quando i tassi di crescita, comparati con quelli dei partner confrontabili, collassano.

Non si invecchia tutto in una volta. Anzi a lungo si può credere che l’invecchiamento non ci riguardi. Ma poi la natura, e un sistema economico non sfugge a questa regola, chiede il conto. E di solito questo conto cresce in ragione delle scelte non fatte quando ancora se ne aveva la possibilità. Le nuove imprese nate in Italia non riescono a procurare quei benefici in termini di produttività che i confronti internazionali lasciano immaginare.

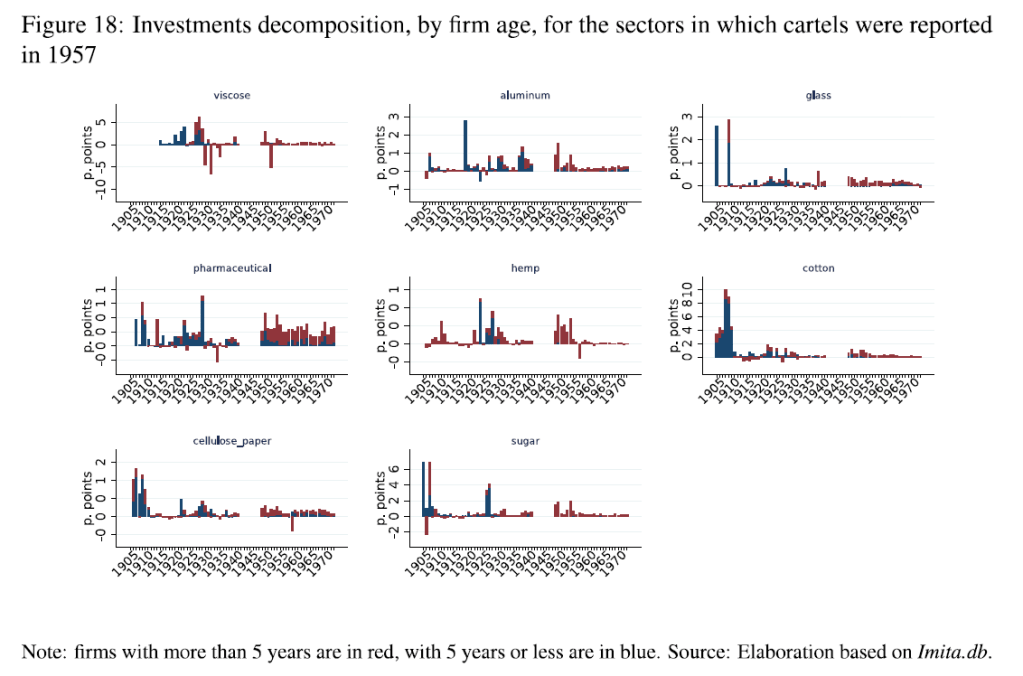

Lo studio si propone proprio di arrivare alla radice di questa “inefficienza” che sembra tipicamente italiana, anche se ci sono diverse evidenze che anche il resto del mondo non se la passi benissimo. E uno degli elementi che fa capire come le radici inevitabilmente influenzino lo sviluppo dell’albero, a meno che non si proceda a metamorfosi profonde, è lo stato dei cartelli che si osservava in Italia ancora nel 1957, quando il paese si avviava al suo effimero boom.

In pratica gli investimenti erano basati su incumbent con notevoli capacità di cartello. I nuovi arrivati, ossia coloro che dovrebbero “sovvertire” i mercati con la loro distruzione creativa erano praticamente tagliati fuori.

Ciò ha comportato che la salute economica italiana è durata finché queste aziende mature, in gran parte pubbliche, non sono diventate senescenti. L’economia italiana è invecchiata con le sue aziende. I nuovi arrivati sono rimasti in larga parte fuorigioco. E le conseguenze le stiamo vedendo adesso.